AI zmienia nie tylko oblicze pracy wielkich korporacji. Łatwo dostępne, niedrogie modele pozwalają na wdrażanie narzędzi nawet w niewielkich firmach. Benefity są proste do przewidzenia: skrócony czas pozyskania informacji wewnętrznych, automatyzacja procesów i zwiększenie skuteczności w podejmowaniu kluczowych decyzji. Sprawdź, jak zbudować firmowy ChatGPT.

W tym poradniku:

- Jak może działać GPT w Twojej firmie?

- Fine-tuning

- Doszkalanie nie dodaje wiedzy

- Firmowy ChatGPT. Chmura vs self hosted

- AI w chmurze

- Modele hostowane lokalnie

- Fingoweb AI Knowledge Database, czyli nasz ChatGPT

- Poziomy dostępu i bezpieczeństwo

- Dane i ich jakość

- AI w Twojej firmie

Wielkie modele językowe (LLM), modele klasyfikacyjne, regresyjne i wiele innych od dawna dostępne są komercyjnie. Mimo to wiele organizacji, zwłaszcza tych mniejszych, niechętnie korzystało z ML/AI w codziennej pracy. Z różnych powodów: kosztów, bezpieczeństwa danych, dostępu do specjalistów.

Wszystko zmieniło się w 2022 roku wraz z popularyzacją narzędzi opartych o AI, którą zawdzięczamy OpenAI. Obecnie zbudowanie własnego ChatGPT nie jest poza zasięgiem nawet niewielkich organizacji. Takie narzędzie może:

- Odpowiadać na pytania zadawane przez pracowników dotyczące organizacji i pracy wewnątrz firmy.

- Pomagać pracownikom w pozyskiwaniu kluczowych dla nich danych, bez konieczności przekopywania się przez kolejne tabele.

- Wspierać zarząd w podejmowaniu decyzji.

- Skracać czas pomiędzy pytaniem a uzyskaniem informacji.

W poniższym tekście skupimy się głównie na rozwiązaniach, które korzystają z wcześniej “wytrenowanych” modeli językowych.

GPT (generative pretrained transformers) to typ modelu językowego, który w 2018 zaprezentowało OpenAI. To tylko jeden z setek modeli, które możesz wykorzystać by pracowały w Twojej organizacji.

Jak może działać GPT w Twojej firmie?

Musimy rozdzielić ChatGPT od samego modelu GPT. ChatGPT to interfejs nałożony przez OpenAI na model GPT-3.5 i GPT-4 pozwalający na wygodną interakcję. Każda, nawet najmniej techniczna osoba jest w stanie otworzyć okno czatu i zadać pytanie.

Same modele oferowane przez OpenAI możesz wykorzystywać na inne sposoby – przykładowo, doszkalając je i integrując przez API. OpenAI udostępnia platformę do budowania autorskich rozwiązań, a więcej na temat piszemy w naszym artykule dotyczącym GPTs.

Wykorzystując gotowy model, w tym przypadku wielki model językowy (LLM), masz możliwość:

- Doszkolenia modelu (Fine-tuning). Doszkolenie zakłada zmianę lub poprawę parametrów działania modelu poprzez szkolenie na nowych danych. Przykłady poniżej.

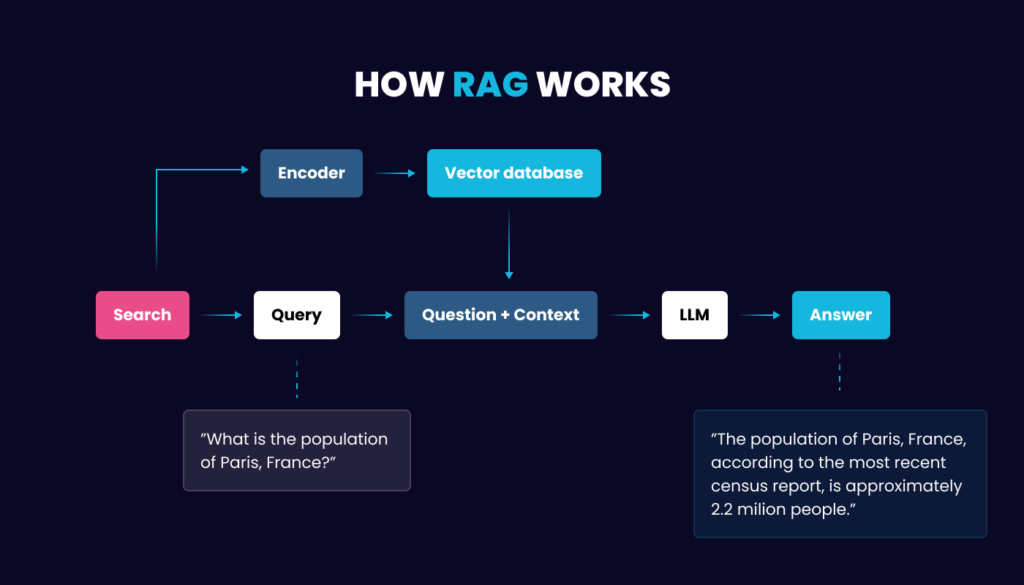

- Skorzystania z metody RAG (Retrieval-Augmented Generation). Model wykorzystuje dedykowany zakres danych, jednak same dane nie zmieniają działania modelu.

Fine-tuning

Aby stworzyć GPT-4 użyto ogromnej ilości danych. OpenAI wprawdzie nie podaje dokładnej liczby, ale wiemy, że starszy model GPT-3 był trenowany na setkach miliardów słów. GPT-4 prawdopodobnie zostało przeszkolone na jeszcze większej ilości danych z książek, stron internetowych i innych tekstów, aby podnieść umiejętności algorytmów w rozumieniu języka naturalnego i generowaniu treści.

Trzy główne cechy GPT to:

- Generowanie tekstu.

- Rozumienie kontekstu i intencji użytkownika.

- Wykonywanie zadań związanych z językiem.

Fine-tuning zakłada dodanie kolejnych zdolności lub poprawę skuteczności w jednej z powyższych.

Poniżej mocno uproszczony przykład, w którym założyliśmy, że chcemy zbudować model do analizy sentymentu recenzji produktów w naszym sklepie online.

- Wybór modelu. Wybieramy model BERT, który został wstępnie wytrenowany na dużym zakresie danych tekstowych, ucząc się rozumienia języka naturalnego i przewidywania następnego zdania.

- Dane treningowe. Zbieramy zestaw danych składający się z recenzji produktów, każda recenzja jest oznaczona oceną sentymentu (np. pozytywny, negatywny, neutralny). Ten zestaw danych jest mniejszy niż oryginalny korpus treningowy BERT, ale specjalnie dostosowany do zadania analizy sentymentu.

- Doszkalanie. BERT dostosowany jest, żeby wyjściowo prezentować wyniki analizy sentymentu i doszkolony nowymi danymi treningowymi.

- Efekt. Po dostrojeniu, model może być używany do analizy sentymentu nowych recenzji produktów.

Doszkalanie nie dodaje wiedzy

Doszkalanie nie dodaje wiedzy, dodaje umiejętności. Doszkalane modele językowe mają szerokie zastosowanie w biznesie, jak w wyżej przytoczonym przykładzie. Jednak, jeśli chcesz zbudować firmowy ChatGPT doszkalanie nie jest potrzebne.

To, czego szukasz to dodanie dedykowanej bazy wiedzy, z której model będzie mógł korzystać odpowiadając na pytania Twoje lub pracowników.

RAG łączy możliwości wstępnie wytrenowanych modeli językowych z systemami wyszukiwania informacji, gdzie odpowiedzi na pytania generowane są w oparciu o dokumenty i dostarczone przez Twoją organizację informacje.

Przykładem rozwiązania korzystającego z gotowego modelu LLaMA i metody RAG jest Fingoweb AI Knowledge Database, o którym niżej.

Firmowy ChatGPT. Chmura vs self hosted

Największą przewagą korzystania z metody RAG jest łatwość wdrożenia i wysoka skuteczność. RAG w połączeniu z model open source to:

- Mnogość wyboru i modele dostosowane do specyficznych potrzeb (NLP, text-to-speach, GPT, computer vision), przetrenowane na dużej ilości danych.

- Niski koszt wdrożenia: finansowy i czasowy.

- Rozbudowana dokumentacja techniczna.

- Możliwość doboru modelu do potrzeb (ilości danych) i możliwości technicznych, np. ograniczeń sprzętowych.

Bez względu na dobór modelu, budowanie rozwiązania wymaga dostarczenia wewnętrznych, firmowych danych (np. informacji na temat klientów, wolumenu sprzedaży, urodzin szefa). Na etapie wyboru rozwiązania trzeba zastanowić się, czy lepiej integrować się z chmurą, czy stworzyć narzędzie hostowane wewnętrznie.

AI w chmurze

W kwestii platform chmurowych wybór jest bardzo duży i oferowany w ramach usług Amazon, Google, IBM, OpenAI oraz innych organizacji. Amazon posiada platformę SageMaker, Google – Vertex AI, IBM – Watsona, a to tylko lista najbardziej znanych i największych korporacji.

Każda z platform to kompleksowe narzędzia do budowania rozwiązań ML/DL i AI. Poczynając od procesu opisywania danych, budowania modelu, trenowania i walidacji, przez hostowanie i integrację.

AI w chmurze – największe plusy

- Sprawdzone narzędzia od gigantów branży technologicznej.

- Ogromny wybór rozwiązań, w tym modeli i integracji.

- W teorii (jeśli masz budżet) nieograniczona moc obliczeniowa.

AI w chmurze – największe minusy

- Zamknięcie się wewnątrz usług chmurowych dostawcy.

- Konieczność wysłania danych w chmurę.

- Wysokie koszty – liczone najczęściej wedle „zużycia” (za godzinę pracy urządzenia, per sztukę wygenerowanego obrazu, za ilość interakcji z modelem itd).

Modele hostowane lokalnie

Alternatywą dla wielkich korporacji będą modele open source, które możesz hostować lokalnie. Co więcej, Twój wewnętrzny ChatGPT może być dostępny tylko z poziomu intranetu, a danymi zarządza Twoja organizacja.

Istnieje szereg bibliotek i frameworków, które można wykorzystać, żeby oparte o AI model uruchomić. Wśród nich TensorFlow, PyTorch czy platforma PaddlePaddle.

Własne AI – największe plusy

- Bezpieczeństwo danych i pełna kontrola.

- Mnogość rozwiązań open source na rynku.

- Brak stałych kosztów.

Własne AI – największe minusy

- Konieczność zakupu i utrzymania hardware'u.

- Wiedza wymagana przy doborze, trenowaniu i wdrażaniu modelu.

W zależności od modelu może wystarczyć nawet przeciętna karta graficzna. LLAMA2-70B wymaga dedykowanego rozwiązania, w moim odczuciu minimum 2 x 24GB albo 1x48GB na kartach graficznych. Wszystko zależy od potrzeb i modelu.

Fingoweb AI Knowledge Database, czyli nasz ChatGPT

Jako software house z Krakowa zatrudniający ponad 50 pracowników posiadamy szereg dokumentów dotyczących procedur, onboardingu, pracy z naszymi klientami. Wykorzystując model LLaMA2 przygotowaliśmy Fingoweb AI Knowledge Database, czyli narzędzie pozwalające pozyskiwać informacje wewnętrzne przy użyciu języka naturalnego.

Fingoweb AI Knowledge Database agreguje dane organizacji i daje możliwość naszym pracownikom w szybki i bezpośredni sposób znaleźć niezbędne informacje.

W przypadku naszego wewnętrznej bazy skupiliśmy się na:

- Informacjach organizacyjnych dotyczących urlopów, zasad działania firmy i struktury organizacyjnej.

- Onboardingu pracowników.

Dla Twojej organizacji zakres danych może być zupełnie inny. LLaMa 3 może pracować z dokumentami PDF, z praktycznie każdą formą tekstu oraz arkuszami kalkulacyjnymi.

NAJWIĘKSZY PLUS:

W naszym przypadku, największym benefitem uruchomienia AI Knowledge Database było skrócenie czasu pozyskania informacji. Zamiast pisania na Slacku do kolejnych osób by znaleźć odpowiedź, prosty interfejs pozwala otrzymać ją w kilka sekund.

Poziomy dostępu i bezpieczeństwo

Poszczególni pracownicy mają dostęp tylko do określonego przez administratora poziomu. Model można uzupełniać o wiedzę na bieżąco, aktualizując dataset poprzez dodanie kolejnych plików.

To od Ciebie zależy, jakie dane chcesz umieścić w narzędziu, a wybór powinna definiować biznesowa potrzeba. Przykładowo: firma posiadająca duży dział handlowy może zbudować rozwiązanie pomagające handlowcom analizować notatki ze spotkań z klientami. Warunkiem jest oczywiście posiadania takich notatek na wstępie.

Dane i ich jakość

W przypadku fine-tuningu jakość i ilość danych jest kluczowa dla efektu końcowego. Metoda RAG pozwala na dynamiczne podmienianie bazy wiedzy, więc w teorii i w praktyce możesz dodać jeden PDF, a narzędzie nadal będzie działać.

AI w Twojej firmie

Budowa i implementacja narzędzia na wewnętrzny użytek organizacji może znacząco podnieść konkurencyjność i skrócić czas podejmowania kluczowych decyzji. Ilość możliwości dostępnych na rynku jest ogromna, a ograniczeniem będzie tylko budżet i czas.

Narzędzia wykorzystujące modele AI nie są rozwiązaniem wszystkich problemów organizacji. Mogą jednak usprawnić procesy i pchnąć organizację w kierunku transformacji cyfrowej.

ChatGPT dla biznesu – najczęściej zadawane pytania

Czy budowa narzędzia opartego o AI jest droga?

Wszystko zależy od potrzeb Twojej organizacji. Budowanie modelu od zera będzie bardziej kosztowne niż fine-tuning istniejącego, a metoda RAG w połączeniu z modelem open-source będzie najtańsza finansowo i czasowo.

Jakie są największe plusy z narzędzia hostowanego wewnętrznie?

Przede wszystkim bezpieczeństwo danych i brak stałych kosztów.

Jaki jest typ danych, które możemy używać korzystając z metody RAG?

Każdy format danych jest OK, pod warunkiem dostosowania do modelu. LLaMA2, na bazie której zbudowaliśmy Fingoweb AI Knowledge Database, obsługuje PDFy, pliki tekstowe oraz arkusze kalkulacyjne.